刘威威教授团队三篇论文被机器学习顶级会议NeurIPS 2022录用

近日,武汉大学多媒体网络通信工程湖北省重点实验室刘威威教授团队三篇论文被机器学习顶级会议NeurIPS 2022录用,武汉大学计算机学院为该三篇论文唯一署名单位,刘威威教授为该三篇论文唯一通讯作者,2020级博士生马新松,2020级博士生李喜园,2020级硕士生许景源为三篇论文第一作者。

神经信息处理系统大会(Neural Information Processing Systems,简称NeurIPS)是由NeurIPS基金会主办的机器学习国际顶级会议。今年举办的NeurIPS2022共收到有效投稿论文10411篇,录用率为25.6%。

论文介绍:

论文题目: On the Tradeoff Between Robustness and Fairness

作者:Xinsong Ma, Zekai Wang, Weiwei Liu

指导教师:刘威威

工作简介:在平衡数据集上经过自然训练的模型对于不同类的预测能力通常比较接近。但对抗训练后的模型却在一些类上表现较好,而在另外一些类上表现较差,即模型在不同类上的标准准确率和鲁棒准确率具有明显差异(Disparity)。本文深入研究了这一问题,并发现更强的对抗训练能够有效提高模型在不同类上的平均鲁棒准确率,但在不同类上鲁棒准确率的差异也会随之明显增大,即模型的鲁棒性与公平性之间存在权衡(Tradeoff)。而导致这一现象的原因是对抗训练具有一种潜在的偏好:对抗训练更加专注于学习鲁棒类的分布而忽视了易受攻击的类。此外,本文也从理论上证明了对抗训练相对于自然训练更容易导致公平性问题。为了解决这一问题,本文提出了一种新的训练方法FAT(Fairly Adversarial Training),并通过大量的实验验证了FAT的有效性。

论文题目:Defending Against Adversarial Attacks via Neural Dynamic System

作者: Xiyuan Li, Xin Zou, Weiwei Liu

指导教师:刘威威

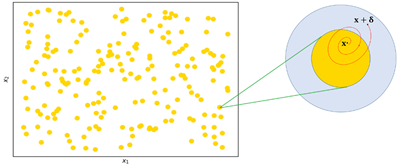

工作简介:DNN容易被攻击的性质阻碍了其在安全关键领域的应用。为了解决这个问题,最近的一些研究提出从动力系统的角度来增强DNN的鲁棒性。根据这一思路,我们受到非自治动力系统的渐近稳定性的启发,将每个自然样本都变成缓慢时变动力系统的渐近稳定平衡点,以防御对抗攻击。我们根据动力系统平衡点理论提出: 如果一个自然样本是一个渐近稳定的平衡点,而对抗样本在这个平衡点附近,那么渐近稳定性可以降低对抗噪声,使对抗样本接近自然样本。在这个理论结果的基础上,我们发明了一种基于非自治神经常微分方程的算法(ASODE),并对其相应的线性系统施加约束,使所有自然样本成为动力系统的渐近稳定平衡点。通过分析,这些约束可以通过转换为损失函数中的正则化项来实现。实验结果表明,ASODE提高了DNN的鲁棒性,并且优于现有的方法。

图1.对抗样本收敛到自然样本的轨迹图

论文题目:On Robust Multiclass Learnability

作者:Jingyuan Xu, Weiwei Liu

指导教师:刘威威

工作简介:本文在PAC(Probably Approximately Correct)框架下证明了,经典理论中研究(非鲁棒)多分类问题下函数类可学习性的重要工具——Natarajan维度或graph维度——无法刻画函数类的鲁棒可学习性。对此,我们定义了AN维度和AG维度(Adversarial Natarajan Dimension & Adversarial Graph Dimension),基于此导出了学习鲁棒分类器所需样本复杂度的一个上界与下界。此外作者研究了这两个定义的诸多性质。本文为填补鲁棒学习领域多分类理论的空白做出了重要贡献。